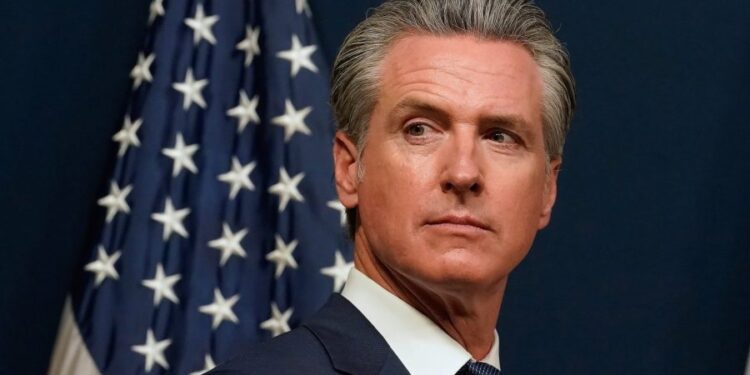

El gobernador de California, Gavin Newsom (D), firmó el lunes un proyecto de ley que establece nuevas barreras sobre cómo los chatbots de inteligencia artificial (IA) interactúan con los niños y manejan los problemas de suicidio y autolesión.

La SB 243, que fue aprobada por la Legislatura estatal a mediados de septiembre, requiere que los desarrolladores de “chatbots complementarios” creen protocolos que impidan que sus modelos produzcan contenido sobre ideas suicidas, suicidio o autolesiones y dirijan a los usuarios a servicios de crisis si es necesario.

También requiere que los chatbots emitan notificaciones “claras y visibles” de que se generan artificialmente si alguien pudiera ser razonablemente engañado haciéndole creer que estaba interactuando con otro ser humano.

Al interactuar con niños, los chatbots deben emitir recordatorios cada tres horas de que no son humanos. Los desarrolladores también deben crear sistemas que impidan que sus chatbots produzcan contenido sexual explícito en conversaciones con menores.

“Las tecnologías emergentes como los chatbots y las redes sociales pueden inspirar, educar y conectar, pero sin barreras de seguridad reales, la tecnología también puede explotar, engañar y poner en peligro a nuestros niños”, dijo Newsom en un comunicado.

“Hemos visto algunos ejemplos verdaderamente horribles y trágicos de jóvenes perjudicados por la tecnología no regulada, y no nos quedaremos de brazos cruzados mientras las empresas continúan sin los límites y la responsabilidad necesarios”, añadió. “Podemos seguir siendo líderes en inteligencia artificial y tecnología, pero debemos hacerlo de manera responsable, protegiendo a nuestros niños en cada paso del camino. La seguridad de nuestros niños no está a la venta”.

La familia de un adolescente de California demandó a OpenAI a finales de agosto, alegando que ChatGPT alentó a su hijo de 16 años a suicidarse. El padre, Matthew Raine, testificó ante un panel del Senado el mes pasado, junto con otros dos padres que acusaron a los chatbots de llevar a sus hijos al suicidio o la autolesión.

OpenAI elogió el lunes la firma del proyecto de ley sobre chatbots como un “avance significativo en lo que respecta a los estándares de seguridad de la IA”.

“Al establecer barreras claras, California está ayudando a dar forma a un enfoque más responsable para el desarrollo y despliegue de la IA en todo el país”, dijo un portavoz en un comunicado.

Las crecientes preocupaciones sobre cómo interactúan los chatbots de IA con los niños llevaron a la Comisión Federal de Comercio (FTC) a lanzar una consulta sobre el tema, solicitando información a varias empresas tecnológicas líderes.

Los senadores Josh Hawley (R-Mo.) y Dick Durbin (D-Ill.) también introdujeron una legislación a finales del mes pasado que clasificaría los chatbots de IA como productos para permitir a los usuarios perjudicados presentar reclamaciones de responsabilidad.

La medida de California es la última de varios proyectos de ley relacionados con la tecnología y la inteligencia artificial promulgados por Newsom en esta sesión. El lunes, también aprobó medidas que exigen etiquetas de advertencia en las plataformas de redes sociales y verificación de la edad por parte de los sistemas operativos y tiendas de aplicaciones.

A finales de septiembre, él también firmó la SB 53que requiere modelos de IA de vanguardia para publicar marcos que detallen cómo evalúan y mitigan los riesgos catastróficos.

Actualizado a las 6:50 pm EDT